Es común quejarse de los que se quejan: hacen catarsis, y no aportan soluciones, les recriminan. Investigadores bonaerenses del Conicet encontraron la forma, echando mano a la inteligencia artificial, de convertir los reproches en un insumo para políticas públicas. En particular, enfocaron la lente en la red virtual Twitter, y dentro de ella fueron por las críticas y enojos relacionados con el tránsito. Utilizaron algoritmos, aplicaciones, Data Mining –extracción de información significativa de grandes bases de datos–, Big Data para grandes volúmenes de datos, Deep Learning –tecnología de aprendizaje y clasificación basada en redes de neuronas artificiales numéricas– para volver productivos los posteos de enojo.

Las ciudades cada vez más inteligentes suman excesivo volumen de información en las redes sociales, y el tránsito no escapa a este fenómeno. Por ejemplo, en Twitter, los usuarios se quejan de los servicios públicos. En particular, de los relacionados con el tránsito: una línea de subte que no funciona –donde las hay–, un siniestro vial que interfiere el paso, una calle cerrada por variados motivos, baches o semáforos fuera de servicio, entre un frondoso abanico de problemas que complican la vida diaria. Agencias gubernamentales y medios de comunicación ya tomaron nota de ese caudal y esa elección para comunicar, entre otras cosas, el descontento. Y utilizan la red del pajarito como una herramienta de comunicación. Bueno en principio. El inconveniente se presenta con el gigantesco volumen de datos volcados, y el vértigo con que se suceden y terminan perdiéndose. “Es por ello que, a partir del uso de Inteligencia Artificial, podemos utilizar técnicas de clasificación”, explicó Luis Berdun, doctor en Ciencias de la Computación que trabaja en el grupo de Sistemas Inteligentes del Instituto Superior de Ingeniería de Software Tandil (Isistán).

El Instituto de Sistemas nació en la Facultad de Ciencias Exactas de la Universidad Nacional del Centro de la Provincia de Buenos Aires (UNCPBA). Su vinculación con el Conicet en 2011 derivó en una Unidad Ejecutora que pasó a llamarse Instituto Superior de Ingeniería de Software Tandil. Allí funcionan cuatro grupos: Sistemas de Recomendación, Sistemas Inteligentes, Computación Distribuida y Móvil y Metodologías y Herramientas para Diseño de Software.

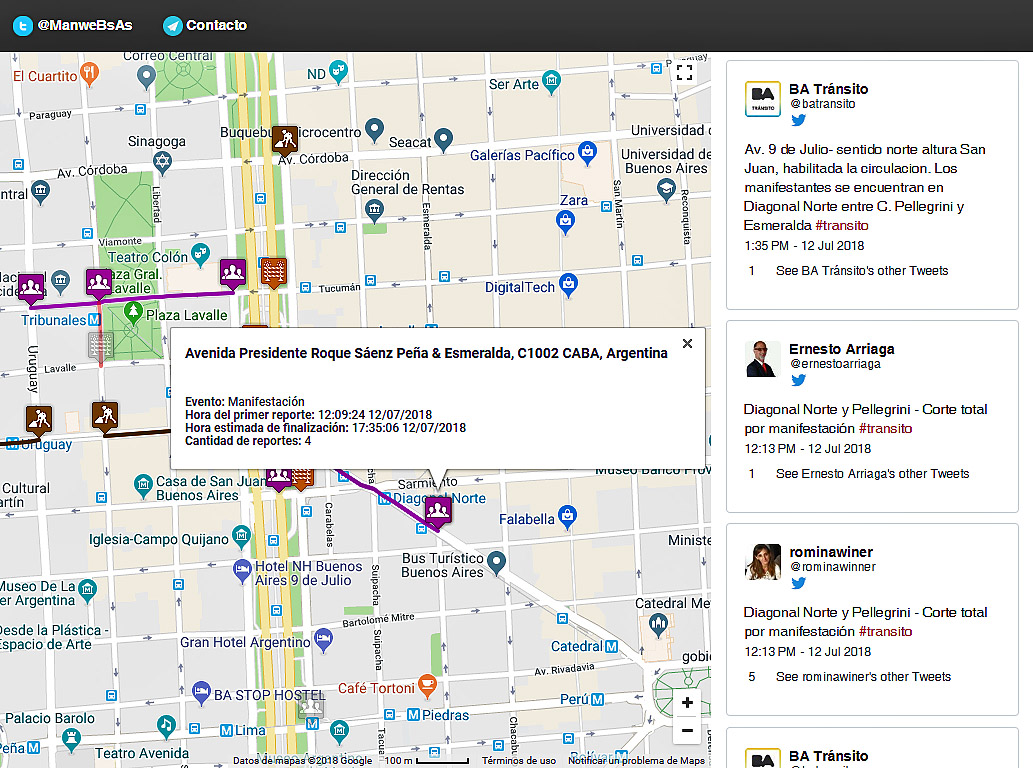

Mapa interactivo con técnicas matemáticas y neuronales

El grupo de Berdun se dedica a Sistemas Inteligentes. Aplican los conceptos de Inteligencia Artificial, entre otros temas, para detectar tuits y cuando están hablando de incidentes de tránsito, ubicarlos en un mapa y transformarlos en información útil. “Tomamos todo este bruto que se procesa. Es como un embudo, detectamos cuáles de esos posteos están hablando de tránsito y con técnicas de procesamiento de lenguaje y de geocodificación, en qué lugar exacto del mapa se produjo el hecho denunciado. El sistema tiene que poder interpretarlo como la locación exacta, a partir de ahí se agrupa y refina esa información para que sea útil. Si conocemos la rutina del usuario, le podemos avisar de los incidentes que lo afectan”, explica el investigador.

El desarrollo es aplicación de una tesis de grado de Brian Caimmi y Sebastián Vallejos, becarios doctorales del Conicet. El objetivo es diseñar y desarrollar una plataforma para ciudades inteligentes que provea servicios tecnológicos de alto nivel (llamados Stan) para entregar insumos a aplicaciones que los utilicen para ofrecer información pertinente a los usuarios o agencias estatales. El trabajo será articulado con el Municipio de Tandil y la meta inmediata es un prototipo para, en una segunda etapa, vincularse con empresas del Parque Científico Tecnológico regional.

Para el estudio de IA se utilizan algoritmos y aplicaciones, así como Data Mining –extracción de información significativa de grandes bases de datos–, Big Data y la lógica de aprendizaje basada en redes neuronales numéricas Deep Learning. Ese gran volumen de información se procesa en un clúster, o conjunto de computadoras.

Comentarios